Infrastruktura pamięci masowej odgrywa kluczową rolę w wspieraniu zaawansowanych aplikacji sztucznej inteligencji (AI) i uczenia maszynowego (ML). Firmy coraz częściej szukają efektywnych rozwiązań, które zapewnią im nie tylko niezawodność, ale także wydajność i skalowalność potrzebną do przetwarzania ogromnych ilości danych. Supermicro, jako lider w dziedzinie rozwiązań serwerowych i pamięci masowej, oferuje kompleksowe architektury pamięci masowej zaprojektowane specjalnie dla obciążeń związanych z AI (artificial intelligence) i ML (machine learning).

Spis treści

- Wprowadzenie

- Co wyróżnia architekturę pamięci masowej Supermicro?

- Pamięć masowa na miejscu (On-Premises Object Storage)

- Wysokowydajne magazyny z pełną matrycą flash

- Przechowywanie danych na GPU (GPU Direct Storage)

- Zasoby akceleracji GPU (GPU-Enabled Resources)

- Serwery Supermicro nadające się do zastosowań AI

- Zalety architektury pamięci masowej Supermicro

- Optymalizacja wydajności i pojemności

- Pełny potencjał AI dzięki infrastrukturze Supermicro

- Szkolenie na dużą skalę

- HPC/AI

- AI dla przedsiębiorstw

- Podsumowanie

Co wyróżnia architekturę pamięci masowej Supermicro?

Supermicro, we współpracy z AMD, oferuje kompleksowe rozwiązania pamięci masowej, które doskonale wspierają obciążenia związane z sztuczną inteligencją (AI) i uczeniem maszynowym (ML). W ramach tych rozwiązań firma dostarcza:

Pamięć masowa na miejscu (On-Premises Object Storage)

Supermicro proponuje rozwiązania oparte na chmurze, które zapewniają ciągłość działania w przypadku awarii oraz kontynuację działalności biznesowej. To idealna opcja dla firm, które potrzebują niezawodnego i skalowalnego sposobu przechowywania i zarządzania swoimi danymi.

Wysokowydajne magazyny z pełną matrycą flash (All-Flash High-Performance Storage Tier)

Supermicro oferuje rozwiązania, które umożliwiają efektywne wykorzystanie pojemności magazynu, równoważąc szybką pamięć flash z pojemnością pamięci obiektowej. Dzięki temu użytkownicy mogą osiągnąć optymalne rezultaty przy przetwarzaniu i analizie dużych ilości danych związanych z AI i ML.

Przechowywanie danych na GPU (GPU Direct Storage)

Rozwiązania Supermicro umożliwiają bezpośredni dostęp do pamięci masowej przez karty graficzne, co przyspiesza przetwarzanie danych związanych z AI i ML. To kluczowy element w zoptymalizowaniu wydajności procesów sztucznej inteligencji i uczenia maszynowego.

Zasoby akceleracji GPU (GPU-Enabled Resources)

Supermicro dostarcza specjalnie zaprojektowane rozwiązania, które umożliwiają efektywne wykorzystanie zasobów obliczeniowych przez karty graficzne. Te zasoby są kluczowe dla przetwarzania zadań związanych z AI i ML, które wymagają intensywnych obliczeń.

Dzięki tym rozwiązaniom, Supermicro zapewnia firmom kompleksową i wydajną infrastrukturę pamięci masowej, która doskonale spełnia potrzeby związane z rosnącymi wymaganiami w obszarze sztucznej inteligencji i uczenia maszynowego.

Serwery Supermicro nadające się do zastosowań AI

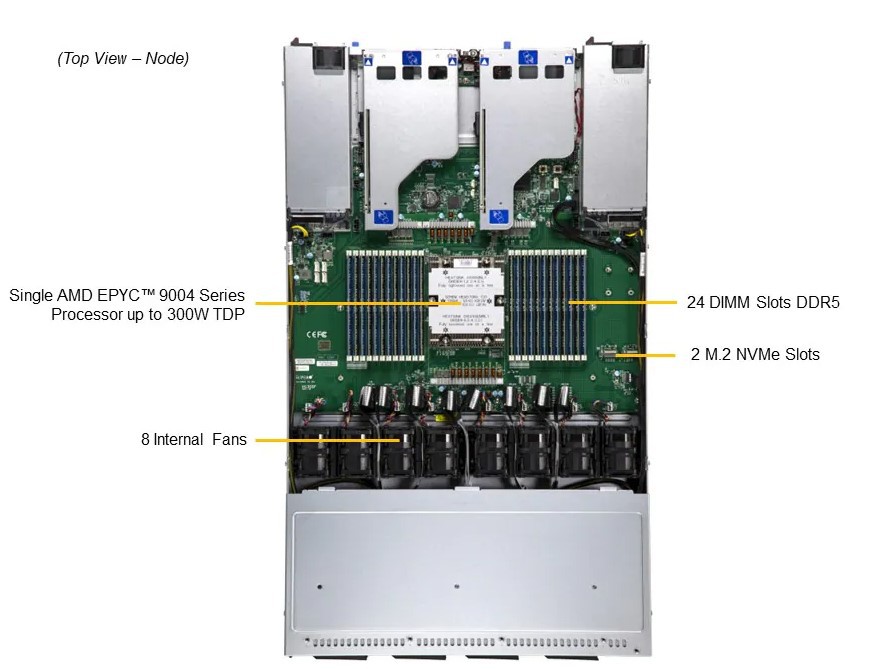

Serwery Supermicro są idealnym rozwiązaniem dla przedsiębiorstw, które potrzebują wydajnej infrastruktury do zadań związanych z sztuczną inteligencją (AI) i uczeniem maszynowym (ML). Na przykład, serwer Supermicro GPU SuperServer SYS-821GE-TNHR oferuje zaawansowane funkcje, takie jak 4. generacja procesorów AMD EPYC™ 9004 Series, obsługujących do 256 rdzeni i 512 wątków, oraz możliwość obsługi do 3 kart graficznych. W połączeniu z pamięcią masową NVMe/SAS/SATA oraz wsparciem do 32 slotów pamięci RAM, serwer zapewnia niezrównaną wydajność w przetwarzaniu danych związanych z AI i ML.

Podobnie, serwery takie jak Supermicro GPU A+ Server AS -4125GS-TNRT oraz Storage A+ ASG-1115S-NE316R oferują wszechstronne możliwości konfiguracyjne, umożliwiając klientom elastyczne dostosowanie infrastruktury do ich potrzeb. Dzięki obsłudze do 128 rdzeni i 256 wątków, oraz pamięci DDR5 o pojemności do 3TB, te serwery zapewniają potężne środowisko obliczeniowe, idealne dla zadań AI i ML. Dodatkowo, zabezpieczenia sprzętowe i oprogramowanie zarządzania pozwalają na bezpieczne i efektywne wykorzystanie zasobów serwerowych, co czyni je idealnym rozwiązaniem dla wymagających aplikacji związanych z analizą danych i uczeniem maszynowym. Serwery Supermicro stanowią solidne fundamenty dla infrastruktury AI, zapewniając niezawodność, wydajność i elastyczność potrzebną do obsługi najbardziej wymagających zastosowań w dziedzinie sztucznej inteligencji.

Zalety architektury pamięci masowej Supermicro obsługujące obciążenia sztucznej inteligencji i uczenia maszynowego

Optymalizacja wydajności i pojemności

Architektura pamięci masowej Supermicro zapewnia równowagę pomiędzy wysoką wydajnością a dużą pojemnością, co pozwala efektywnie zarządzać danymi związanymi ze sztuczną inteligencją i uczeniem maszynowym. Rozwiązania te wykorzystują najnowsze osiągnięcia technologiczne, takie jak pamięci flash PCIe Gen 5 oraz procesory AMD EPYC™ 9004 serii CPU, aby zapewnić zarówno wydajność, jak i skalowalność.

Pełny potencjał AI dzięki infrastrukturze Supermicro

Supermicro oferuje innowacyjne rozwiązania infrastruktury gotowej do obsługi wszystkich rodzajów obciążeń związanych ze sztuczną inteligencją. Od szkolenia na dużą skalę, po wnioskowanie na krawędzi, kompleksowe projekty referencyjne upraszczają i przyspieszają wdrożenie AI. Pozwala to wzbogacić swoje obciążenia optymalną wydajnością i skalowalnością, jednocześnie optymalizując koszty i minimalizując wpływ na środowisko. Tym samym można odkryć świat możliwości dzięki różnorodnym, zoptymalizowanym pod kątem obciążeń AI rozwiązaniom Supermicro i przyspieszyć każdy aspekt swojego biznesu.

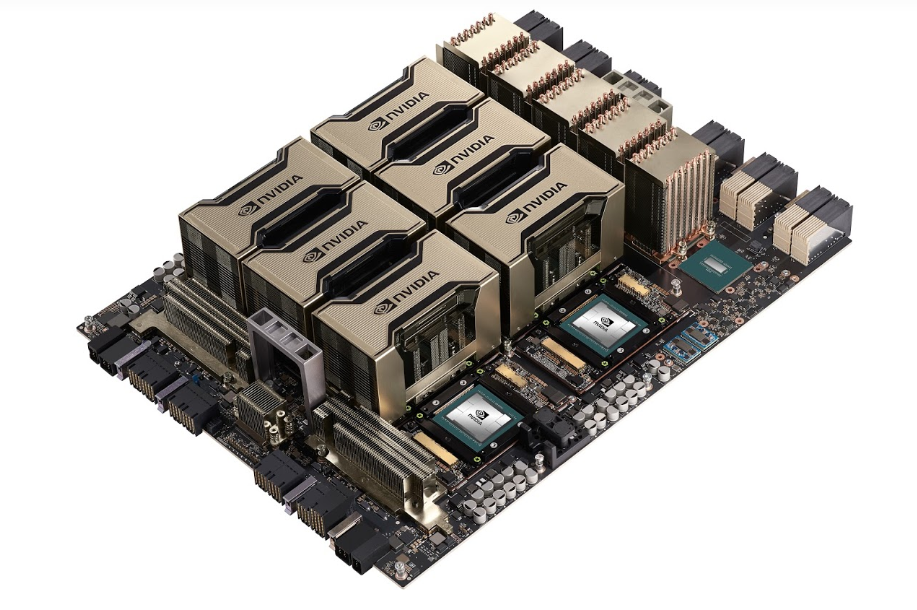

Szkolenie na dużą skalę

Szkolenie na dużą skalę AI wymaga innowacyjnych technologii, które maksymalizują moc obliczeniową równoległą kart graficznych do obsługi miliardów, jeśli nie bilionów parametrów modeli AI, które mają być szkolenie z ogromnymi zbiorami danych, które rosną wykładniczo. Wykorzystując NVIDIA DELTA HGX A100 SXM4 oraz najwyższej jakości połączenia między GPU NVlink® & NVSwitch® o przepustowości do 900 GB/s, oraz najwyższe prędkości sieciowe 1:1 do każdego GPU dla klastrów węzłów, systemy te są zoptymalizowane do szkolenia dużych modeli językowych od podstaw w najkrótszym możliwym czasie. Kompletując układ wszystkimi pamięciami NVMe typu all-flash dla szybkiego potoku danych AI, dostarczamy w pełni zintegrowane szafy z opcjami chłodzenia cieczą, aby zapewnić szybkie wdrożenie i płynne doświadczenie szkolenia AI.

HPC/AI

Przyspieszanie czasu odkrywania dla naukowców, badaczy i inżynierów wymaga coraz większego wykorzystania algorytmów uczenia maszynowego i obliczeń równoległych akcelerowanych przez GPU w celu uzyskania szybszych wyników. Wiele z najbardziej wydajnych klastrów superkomputerowych na świecie wykorzystuje teraz karty graficzne i moc AI. Obciążenia HPC zazwyczaj wymagają symulacji i analiz danych z dużymi zestawami danych i precyzyjnymi wymaganiami. Karty graficzne takie jak HGX H100 od NVIDII zapewniają niespotykaną wydajność podwójnej precyzji, oferując 60 teraflopsów na kartę graficzną, a elastyczne platformy HPC Supermicro pozwalają na dużą liczbę kart graficznych i procesorów w różnych gęstych formatach z integracją na skalę szafy serwerowej i chłodzeniem cieczą.

AI dla przedsiębiorstw

Wzrost AI generatywnej został uznany za kolejną przestrzeń dla różnych branż, od technologii po bankowość i media. Wyścig o przyjęcie AI rozpoczął się jako źródło innowacji, znacznego zwiększenia produktywności, uproszczenia operacji, podejmowania decyzji opartych na danych i poprawy doświadczenia klienta. Bez względu na to, czy są to aplikacje i modele biznesowe wspomagane przez AI, inteligentne chatboty podobne do ludzi do obsługi klienta, czy AI do generowania kodu i tworzenia treści, przedsiębiorstwa mogą wykorzystać otwarte ramy pracy, biblioteki, wstępnie szkoleniowe modele AI i dostosować je do unikalnych przypadków użycia z własnym zbiorem danych. W miarę jak przedsiębiorstwo przyjmuje infrastrukturę AI, różnorodność optymalizowanych pod kątem obciążeń GPU systemów Supermicro zapewnia otwartą modułową architekturę, elastyczność dostawcy i łatwe ścieżki wdrożenia i aktualizacji dla technologii, które dynamicznie się rozwijają.

Podsumowanie

Supermicro i AMD stawiają na nowe standardy w obszarze infrastruktury pamięci masowej, oferując zaawansowane rozwiązania zoptymalizowane pod kątem obciążeń związanych ze sztuczną inteligencją (AI) i uczeniem maszynowym (ML). Dzięki innowacyjnym architekturom pamięci masowej, które obejmują pamięć masową na miejscu, wysokowydajne magazyny z pełną matrycą flash oraz rozwiązania umożliwiające przechowywanie danych na GPU, Supermicro umożliwia firmom efektywne zarządzanie dużymi ilościami danych oraz przyspiesza procesy analizy i wdrażania rozwiązań opartych na sztucznej inteligencji. To kompleksowe podejście do pamięci masowej, połączone z szybką integracją stojaka, pozwala firmom maksymalizować swoje inwestycje w AI i ML, otwierając drzwi do nowych możliwości i przyspieszając innowacje w zakresie analizy danych. Supermicro i AMD są liderami w dziedzinie infrastruktury pamięci masowej, dostarczając rozwiązania, które nie tylko spełniają, ale przekraczają oczekiwania w zakresie wydajności, skalowalności i innowacyjności.

Zaloguj się